f(x)= \frac{1}{\sigma \sqrt{2\pi}} exp ( - \frac{\mu-x}{2\sigma^2})

f(x)=\frac{1}{nh}\sum_{i=1}^n K(\frac{\mu-X_i}{h})

a kernel Gausowski:

K(u)=\frac{1}{\sqrt{2\pi}}exp(-u^2/2)

Wektor średnich: m=(m_1,m_2)

Macierz kowariancji: \Sigma

f(x) = \frac{1}{2\pi\sqrt{|\Sigma|}}exp(-\frac{1}{2}(x-m)^T\Sigma^{-1}(x-m)

Jeżeli X∼N(m,\Sigma) i Y=AX, to:

Y∼N(Am,A \Sigma A^T)

(AB)^T = B^TA^2

jeśli macierze są odwracalna (kiedy wyznacznik \neq 0):

na wykładzie 6 mieliśmy pochodne po macierzach, sprawdź o co biega z tym.

Probability - prawdopodobieństwo - jeśli powiemy jakiejś osobie, aby przewidziała wyników 10 kolejnych rzutów monetą, to najczęściej zgadnie ona 5 z 10; czasem 0, czasem 10, i mamy prawdopodobieństwo zgadnięcie

Likelihood - wiarygodność - jaka jest szansa na to że to wydarzenie które już się wydarzyło, miało szansę na zaistnienie

Kolejna ciekawe spojrzenie na wiarygodność - rzucając raz kostką i dostaniemy 6kę, najbardziej wiarygodną opcją jest to że kostka na 100% daje 6, rzucając więcej razy, spadnie to do \frac{1}{6}.

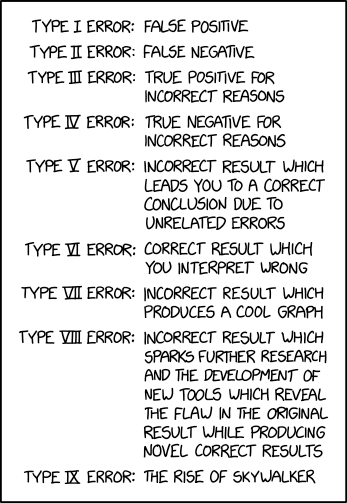

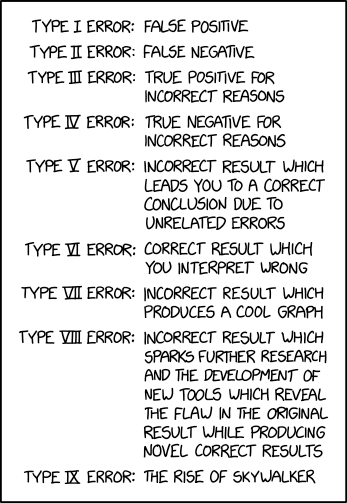

definicje:

1 rodzaju, czyli false positive := odrzucamy hipotezę zerową mimo tego, że jest prawdziwa

2 rodzaju, nie odrzucamy hipotezy zerowej mimo tego że jest fałszywa

A_{\lambda} = A - \lambda I = \begin{bmatrix} 5 & 3 \\ -6 & -4 \end{bmatrix} - \lambda * \begin{bmatrix} 1 & 0 \\ 0 & 1 \end{bmatrix}

potem liczymy z tego wyznacznik. Wartości własne to miejsca zerowe; np. dla \lambda^2-\lambda-2, mamy \lambda_{1}=-1, \lambda_{2}=2; <= to są wartości własne

Następnie, każde z miejsc zerowych podkładamy ma macierzy A_{\lambda} i mnożymy przez macierz \begin{bmatrix} x\\ y \end{bmatrix} <= to są wektory własne

przykład: A_{\lambda_{1}}=\begin{bmatrix} 5-\lambda & 3 \\ -6 && -4-\lambda \end{bmatrix} * \begin{bmatrix}x\\y\end{bmatrix}

Dziękuję eTrapez za przykładowe liczby i fajne wytłumaczenie <333